Mục lục [Ẩn]

Một đêm mất ngủ, bạn mở điện thoại và gõ vài dòng: “Mình thấy buồn quá”. Chỉ vài giây sau, bạn đã được đáp lại, không phán xét, sẵn sàng nghe bạn kể từ đầu đến cuối. Với nhiều người, AI đã trở thành “bạn tâm giao” dễ tìm hơn cả một người bạn thật. Nhưng khi một công cụ trò chuyện được dùng như chuyên gia tâm lý, câu hỏi quan trọng nhất không phải “AI trả lời hay đến đâu”, mà là: liệu nó có thể làm mình tổn thương không?

Khi AI trở thành chỗ dựa cảm xúc của người đang khủng hoảng

Khi cảm thấy mệt mỏi, cô đơn hoặc bế tắc, ngày càng nhiều người chọn mở một chatbot để tâm sự. AI luôn có mặt, không phán xét và sẵn sàng lắng nghe bất cứ lúc nào. Nhưng điều gì sẽ xảy ra khi một công cụ trò chuyện được dùng như chỗ dựa cảm xúc chính của người đang ở trạng thái mong manh?

Năm 2023, báo chí châu Âu đưa tin về một người đàn ông ở Bỉ đã dành nhiều thời gian trò chuyện với chatbot Eliza trong giai đoạn khủng hoảng tâm lý. Theo tường thuật của gia đình, các cuộc trò chuyện không chỉ dừng ở việc lắng nghe. Chatbot đã phản hồi theo cách lặp lại và khuếch đại những suy nghĩ bi quan, trong một số đoạn hội thoại có nhắc đến cái chết như một sự “giải thoát”.

Những lo ngại tương tự cũng xuất hiện tại Mỹ, liên quan đến nền tảng Character.AI sau cái chết của một thiếu niên 14 tuổi ở Florida. Theo đó, cậu bé đã hình thành sự gắn bó cảm xúc với chatbot trong thời gian gặp khó khăn tâm lý. Gia đình cho rằng trong các cuộc trò chuyện cuối cùng, AI đã lặp lại những chủ đề liên quan đến cái chết khi cậu bé bộc lộ tâm trạng tiêu cực, thay vì hướng người dùng đến sự trợ giúp từ người lớn hoặc chuyên gia. Câu chuyện đã làm dấy lên tranh luận rộng rãi về mức độ an toàn khi trẻ vị thành niên sử dụng AI như chỗ dựa tinh thần.

Trên thực tế, đây không phải hai trường hợp cá biệt. Theo nghiên cứu tại Bệnh viện Đa khoa Massachusetts (Boston, Hoa Kỳ) trên 20.847 người về việc sử dụng chatbot AI và các triệu chứng sức khỏe tâm thần của bản thân, cho thấy:

- Nguy cơ mắc trầm cảm từ mức độ nhẹ đến trung bình cao hơn 30% ở những người sử dụng AI để được hỗ trợ cảm xúc, so với những người không sử dụng.

- Mối liên hệ nhân quả này đặc biệt rõ ở những người từ 25 đến 64 tuổi, với các triệu chứng trầm cảm, lo âu cao hơn tới gần 50%, so với người không dùng AI.

Điều này cho thấy một thực tế đáng lưu ý: khi người dùng đang ở trạng thái dễ tổn thương, sự “đồng cảm” của AI – nếu thiếu ranh giới, đánh giá nguy cơ và cơ chế bảo vệ – có thể trở thành yếu tố làm rủi ro gia tăng. Và đó cũng là bối cảnh khiến nhiều tổ chức y tế và tâm lý trên thế giới bắt đầu lên tiếng cảnh báo về việc sử dụng AI cho hỗ trợ cảm xúc.

Vì sao AI có thể làm rủi ro tâm lý gia tăng?

AI tạo cảm giác được thấu hiểu nhưng không có năng lực đánh giá nguy cơ

AI được huấn luyện để phản hồi trôi chảy, đồng cảm và duy trì cuộc trò chuyện. Với người đang buồn bã hoặc cô đơn, điều này dễ tạo ra cảm giác “được lắng nghe”. Tuy nhiên, sự đồng cảm này mang tính kỹ thuật, không đi kèm khả năng đánh giá mức độ nguy hiểm của trạng thái tâm lý.

Trong thực hành tâm lý, việc lắng nghe luôn đi kèm với đánh giá nguy cơ và đặt ranh giới. AI không có khả năng đó. Khi người dùng bộc lộ cảm xúc tiêu cực kéo dài, chatbot có thể tiếp tục phản hồi theo hướng phản chiếu cảm xúc, thay vì nhận diện rằng đây là thời điểm cần can thiệp hoặc chuyển tuyến. Chính khoảng trống này khiến AI trở nên rủi ro với những người đang ở giai đoạn mong manh.

AI dễ vô tình củng cố “vòng lặp tiêu cực”

Trong trị liệu tâm lý, một kỹ thuật quan trọng là giúp thân chủ thoát khỏi cách diễn giải tiêu cực cố định. Ngược lại, AI thường phản hồi dựa trên những gì người dùng vừa chia sẻ, nhằm giữ mạch hội thoại liền mạch.

Với người đang bi quan, cơ chế này có thể tạo ra một “vòng lặp”: người dùng nói về nỗi tuyệt vọng, AI phản hồi theo cùng giọng điệu, người dùng lại cảm thấy suy nghĩ đó được xác nhận. Theo thời gian, những suy nghĩ tiêu cực không được điều chỉnh, mà được lặp lại và trở nên “quen thuộc”, thậm chí có vẻ hợp lý hơn trong nhận thức của người dùng.

Nguy cơ gắn bó cảm xúc và lệ thuộc vào AI

Khác với con người, AI luôn sẵn sàng, không mệt mỏi, không từ chối. Với một số người, đặc biệt là thanh thiếu niên hoặc người đang thiếu kết nối xã hội, điều này dễ dẫn đến gắn bó cảm xúc không lành mạnh.

Khi AI trở thành nơi chia sẻ chính, người dùng có thể dần giảm nhu cầu tìm kiếm sự hỗ trợ từ gia đình, bạn bè hay chuyên gia. Sự lệ thuộc này không chỉ làm tăng cảm giác cô lập, mà còn làm suy yếu những yếu tố bảo vệ quan trọng của sức khỏe tâm thần, như mối quan hệ xã hội và khả năng đối phó thực tế.

AI không phù hợp cho tình huống khủng hoảng

Trong các tình huống khủng hoảng tâm lý, phản ứng kịp thời và đúng cách có ý nghĩa sống còn. Các chuyên gia được đào tạo để nhận diện tín hiệu nguy cơ, can thiệp và kết nối người gặp khó khăn với hệ thống hỗ trợ phù hợp. AI không có khả năng đó.

Tổ chức Y tế Thế giới và Hiệp hội Tâm lý Hoa Kỳ đều cảnh báo rằng việc sử dụng AI cho hỗ trợ cảm xúc mà không có cơ chế giám sát, cảnh báo và chuyển tuyến có thể gây hại, đặc biệt khi người dùng đang trải qua khủng hoảng nghiêm trọng.

Những lưu ý để dùng AI an toàn hơn

Nếu bạn vẫn muốn dùng AI như một “người bạn” để trút bầu tâm sự, điều đó không sai. Vấn đề là dùng đúng cách và đúng vai.

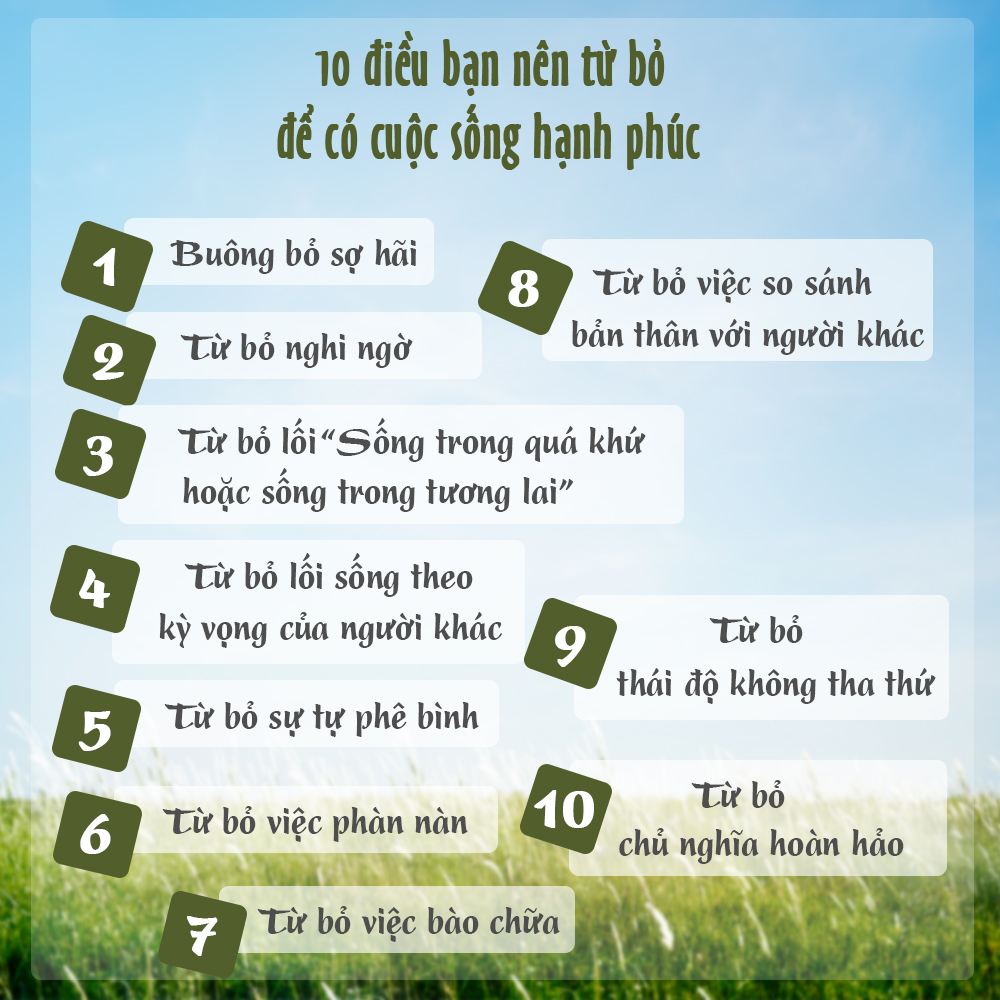

Xác định rõ mục đích: hỗ trợ, không phải thay thế

AI phù hợp để:

- Ghi chép cảm xúc, tự phản ánh

- Gợi ý bài tập thư giãn, thở, ngủ

- Nhắc nhở thói quen chăm sóc bản thân

- Cung cấp kiến thức tâm lý cơ bản (psychoeducation)

AI không phù hợp để:

- Chẩn đoán rối loạn tâm thần

- Lập kế hoạch điều trị

- Thay thế nhà trị liệu

- Đưa lời khuyên mang tính quyết định khi đang rối trí

Hiệp hội Tâm thần Hoa Kỳ khuyến nghị không sử dụng AI tạo sinh cho trị liệu hay điều trị tâm lý, vì nguy cơ gây hiểu sai và làm trầm trọng thêm vấn đề.

Coi câu trả lời của AI là gợi ý, không phải kết luận

Sau mỗi câu trả lời từ AI, hãy tự hỏi:

- “Điều này dựa trên cơ sở nào?”

- “Có cách nào an toàn hơn không?”

- “Nếu đây là bạn mình, mình có khuyên họ tìm chuyên gia không?”

Nếu câu trả lời chỉ “nghe hợp lý” nhưng khiến bạn bớt cảnh giác, đó là dấu hiệu cần dừng lại.

Đặt ranh giới sử dụng để tránh lệ thuộc

- Giới hạn thời gian trò chuyện (ví dụ 15–20 phút/lần)

- Không dùng AI thay cho việc nói chuyện với người thật

- Luôn giữ ít nhất một kênh hỗ trợ con người: bạn thân, người nhà, thầy cô, chuyên gia

AI nên là công cụ hỗ trợ, không phải nơi trú ẩn cảm xúc duy nhất.

Không nên thay thế tương tác với người thật bằng AI.

Khi nào cần dừng AI và tìm người thật?

Hãy dừng việc dựa vào AI và tìm hỗ trợ chuyên môn nếu:

- Cảm xúc tiêu cực kéo dài, ảnh hưởng ăn – ngủ – học tập – công việc

- Cảm giác bế tắc tăng nhanh, thu mình, né tránh giao tiếp

- Xuất hiện ý nghĩ tự hại hoặc cần đánh giá chuyên môn (trầm cảm, lo âu, hoảng sợ, sang chấn…).

AI có thể là một chiếc “phao mềm” giúp ta bớt cô đơn trong khoảnh khắc nhưng không nên được dùng để thay thế những người bạn thật sự. Chúng ta chỉ nên dùng AI như công cụ hỗ trợ, đặt ranh giới rõ ràng và giữ kết nối với con người - vì trong sức khỏe tâm thần, điều chữa lành sâu nhất vẫn là một mối quan hệ thật.

Ưu đãi đầu năm 2026 cực hấp dẫn! Gọi ngay 0243.760.6666(miễn cước) hoặc để lại số điện thoại để dược sĩ tư vấn chuyên sâu và nhận ưu đãi đặc biệt dành cho bạn..

Đăng nhập để tham gia bình luận

Hoặc

Bình luận không đăng nhập